Nello specifico analizzo i nuovi modelli di IA di Open AI e le tecnologie GPT-3

Iniziamo:

Quali sono le tecnologie che riescono ad analizzare e a riproporre qualsiasi linguaggio umano, linguaggi naturali o formali che siano?

Una risposta è la seguente: GPT-3

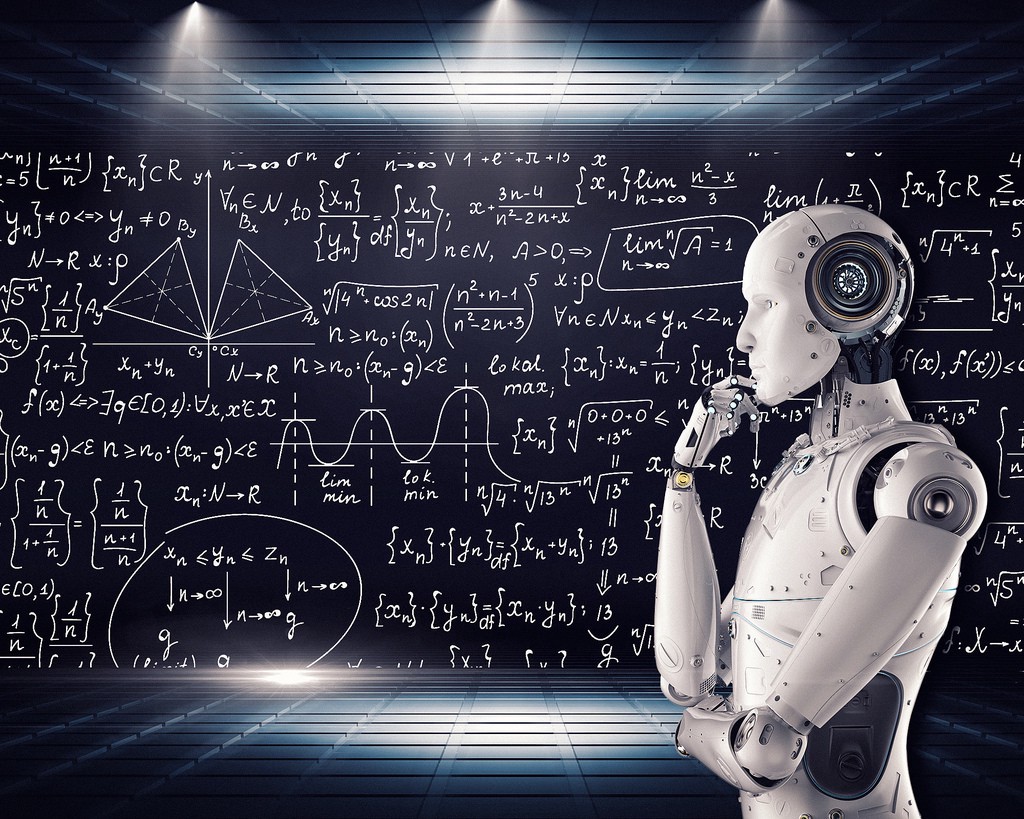

Nel mondo dell’Intelligenza Artificiale, il modello di linguaggio GPT-3 (Generative Pre-trained Transformer 3) dell’azienda OpenAI sta rapidamente conquistando la curiosità del grande pubblico. Siamo di fronte ad un modello che utilizza il deep learning per – ad esempio – comporre poesie, racconti, codice informatico e canzoni in maniera celere, così reali da far pensare a “prodotti” scritti da un essere umano. Gli basta solo un input umano per completare l’opera. Ma l’eloquenza di GPT-3 è molto più che un trucco “da salotto”. I ricercatori infatti ritengono che le tecniche utilizzate per creare GPT-3 potrebbero svelare il segreto di un’Intelligenza Artificiale più avanzata. Tutto bene, dunque? In realtà, la notizia che solo Microsoft avrà accesso al codice di base della GPT-3 ha fatto sollevare più di un sopracciglio. Vediamo perché.

GTP-3 utilizza i suoi algoritmi per generare testo. Questi algoritmi sono stati precedentemente addestrati tramite un enorme database.

Valuta ed elabora tutti i dati che riceve per colmare le lacune informative.

È in grado di generare testo attraverso una singola frase e di completare il resto della scrittura, elaborando oltre 175 miliardi di parametri. Questo dato è molto rilevante, poiché la versione precedente, la GPT-2 presentata nel 2019, elaborava solo 1,5 miliardi di parametri. I progressi in un anno sono stati sorprendenti.

Può tradurre testi in altre lingue e adattarli a diversi stili di scrittura, come il giornalismo, il romanzo, ecc. Può anche scrivere poesie o darci la risposta migliore alla domanda che gli facciamo.

In poche parole, la GTP-3 è in grado di affrontare tutto ciò che è strutturato come una lingua: può rispondere a domande, scrivere saggi, riassumere testi lunghi, tradurre, prendere appunti e persino scrivere codice informatico.

Sì, hai letto correttamente: GTP-3 può anche programmare. Con grande stupore, si è scoperto che è in grado di utilizzare un plug-in per Figma, uno strumento software comunemente usato nella progettazione di applicazioni e siti web. Questa caratteristica potrebbe avere implicazioni epocali per lo sviluppo del codice e del software in futuro.

La quantità di cose che è in grado di fare può sembrare incredibile, ma le sue capacità potenziali sono ancora più stupefacenti

Cos’è il GPT-3 di OpenAI, nuovo modello di intelligenza artificiale

Il GPT-3 si è formato su un’enorme quantità di dati testuali. Ma se addestrassimo tale modello di linguaggio oltre che su testi anche con immagini? Una nuova ricerca dell’Allen Institute for Artificial Intelligence (AI2) sta portando tale domanda alla sua realizzazione. I ricercatori hanno sviluppato un nuovo modello “combinato” di testo e immagini – noto come modello in linguaggio visivo – in grado di generare immagini con una didascalia. Le immagini sembrano dettagliate come i deepfake iperrealistici generati dai GAN (Generative Adversarial Networks o Rete Generativa Avversaria), e potrebbero dimostrare una nuova promettente “direzione” per ottenere una migliore Intelligenza Artificiale, apportando novità interessanti anche al settore della robotica. Il modello GPT-3 in dettaglio

La GPT-3 fa parte di un gruppo di modelli di linguaggio noti come “transformer“, che per primi si sono diffusi con il linguaggio BERT di Google (Bidirectional Encoder Representations from Transformers). Prima del BERT, i modelli linguistici erano piuttosto scadenti; in pratica, avevano abbastanza potere predittivo da essere utili per applicazioni come l’autocompletamento, ma non abbastanza potere per generare una lunga frase che seguisse le regole grammaticali e il senso logico. Il BERT ha cambiato questa situazione introducendo una nuova tecnica chiamata “mascheramento“: si tratta di nascondere parole diverse in una frase e chiedere al modello di riempire il vuoto. L’idea è che se il modello di linguaggio è costretto a fare questi esercizi – spesso milioni di volte – comincia pian piano a scoprire il modo in cui le parole sono assemblate in frasi, nonché come le frasi sono assemblate in paragrafi. Di conseguenza, il testo si avvicina sempre di più al senso compiuto. Dopo che il mascheramento si è rivelato molto efficace, i ricercatori hanno cercato di applicarlo ai modelli di linguaggio visivo nascondendo le parole nelle didascalie delle immagini. Questa volta il modello poteva guardare sia le parole circostanti che il contenuto dell’immagine per riempire il vuoto. Attraverso milioni di ripetizioni, si scoprono non solo i modelli tra le parole, ma anche le relazioni tra le parole e gli elementi di ogni immagine. Il risultato sono modelli in grado di mettere in relazione le descrizioni testuali con i riferimenti visivi, proprio come i bambini possono creare connessioni tra le parole che imparano e le cose che vedono. I modelli possono guardare una foto e redigere direttamente una didascalia, in maniera del tutto autonoma. Oppure possono rispondere a domande come “qual è il colore della palla?” collegando la parola “palla” con l’oggetto sferico presente nell’immagine.Ma i ricercatori di AI2 volevano sapere se questi modelli avevano effettivamente sviluppato una comprensione concettuale del mondo visivo. Un bambino che ha imparato il nome di un oggetto può non solo evocare la parola per identificare l’oggetto, ma anche disegnare l’oggetto “connesso” con la parola, anche se l’oggetto stesso non è presente davanti a lui (ad es. la maestra dà il compito di disegnare un pallone da calcio non partendo da alcuna immagine). Così i ricercatori hanno chiesto ai modelli di fare lo stesso: generare immagini da didascalie, ossia da testi.Nella pratica, trasformare il testo in immagini è molto più difficile che al contrario. Una didascalia non specifica tutto ciò che è contenuto in un’immagine, affermano da AI2. Quindi un modello ha bisogno di attingere a un sacco di informazioni sul mondo che lo circonda. Se gli si chiede di disegnare “una giraffa che cammina su una strada”, per esempio, il modello deve anche dedurre che la strada è più probabile che sia grigia che rosa, ad esempio; oppure che è più probabile che sia vicino a un campo erbaceo che vicino all’oceano, anche se nessuna di queste informazioni è resa esplicita. Così in AI2 hanno deciso di vedere se potevano insegnare a un modello tutta questa conoscenza visiva implicita modificando l’approccio al mascheramento. Invece di addestrare il modello a prevedere le “parole mascherate” nelle didascalie delle foto corrispondenti, l’hanno addestrato a prevedere i pixel mascherati nelle foto sulla base delle didascalie corrispondenti. Le immagini finali generate dal modello non sono state però esattamente realistiche. Ma non è questo il punto. Contengono i giusti concetti visivi di alto livello, l’equivalente dell’Intelligenza Artificiale di un bambino che disegna una figura stilizzata per rappresentare un essere umano.La capacità dei modelli in linguaggio visivo di fare questo tipo di generazione di immagini rappresenta un importante passo avanti nella ricerca sull’Intelligenza Artificiale. Essa suggerisce che il modello è in realtà capace di un certo livello di astrazione, un’abilità fondamentale per la comprensione del mondo. A lungo termine, questo potrebbe avere implicazioni anche nel campo della robotica. Quanto più un robot è in grado di comprendere il suo ambiente visivo e di usare il linguaggio per comunicare su di esso, tanto più complessi saranno i compiti che sarà in grado di svolgere. A breve termine, questo tipo di visualizzazione potrebbe anche aiutare i ricercatori a capire meglio ciò che i modelli di Intelligenza Artificiale stanno imparando. Inoltre, il team prevede di sperimentare di più per migliorare la qualità della generazione di immagini e ampliare il vocabolario visivo e linguistico del modello per includere più argomenti, oggetti e aggettivi.

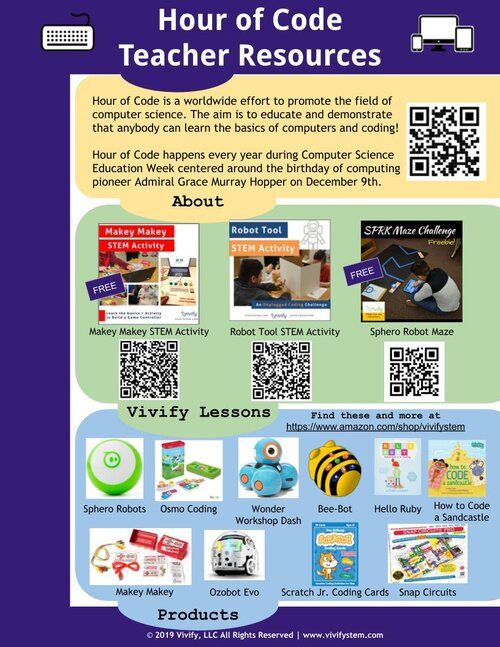

Qui di sotto un video esempio sui suoi possibili utilizzi:

L’avanzata di Microsoft in OpenAI

Il 22 settembre scorso, Microsoft ha annunciato che inizierà a concedere in esclusiva la licenza per GPT-3. Microsoft ha affermato, in pratica, che inizierà ad utilizzare le capacità di questo modello nei suoi prodotti e servizi, anche se non ha specificato i dettagli. Ma cosa significa licenza esclusiva? In pratica OpenAI continuerà a offrire la sua API rivolta al pubblico, permettendo agli utenti di inviare testo a GPT-3 o ad altri modelli di OpenAI e di ricevere degli output. Tuttavia, solo Microsoft avrà accesso al codice di base della GPT-3, permettendo al colosso di Redmond di incorporare, riadattare e modificare il modello a suo piacimento.OpenAI è stata originariamente fondata come una non profit e ha raccolto il suo iniziale miliardo di dollari con la promessa che avrebbe perseguito l’idea di un’Intelligenza Artificiale rivolta “a beneficio dell’umanità”. OpenAI affermava che sarebbe stata indipendente dagli incentivi finanziari dei colossi, e che sarebbe rimasta una non-profit. Ma all’inizio del 2019, OpenAI ha suscitato polemiche quando ha scelto di non rilasciare il predecessore della GPT-3, la GPT-2, e poco dopo ha abbandonato il suo status di puro non-profit per orientarsi verso lo scopo di lucro. All’epoca, molti ipotizzarono che parte del motivo dell’organizzazione per trattenere la GPT-2 potesse essere quello di preservare la possibilità di concedere in licenza il modello in futuro. Nel luglio del 2019, OpenAI ha accettato il suo secondo investimento miliardario da Microsoft. Nei mesi successivi all’investimento di Microsoft, OpenAI ha iniziato a sottolineare la necessità di commercializzare le sue tecnologie per continuare a sostenere il suo lavoro. Le ultime novità consolidano la trasformazione di OpenAI in un’azienda profit.

Ecco quali lavori potrebbe sostituire il gpt-3

Quali sono alcuni dei problemi con GPT-3?

La capacità di GPT-3 di produrre linguaggio è stata salutata come la migliore mai vista nell’IA; tuttavia, ci sono alcune considerazioni importanti.

Lo stesso CEO di OpenAI, Sam Altman, ha dichiarato: “L’hype GPT-3 è troppo. L’IA cambierà il mondo, ma GPT-3 è solo un primo assaggio”.

In primo luogo, è uno strumento estremamente costoso da utilizzare in questo momento, a causa dell’enorme quantità di potenza di calcolo necessaria per svolgere la sua funzione. Ciò significa che il costo di utilizzo sarebbe oltre il budget delle organizzazioni più piccole.

In secondo luogo, è un sistema chiuso o scatola nera. OpenAI non ha rivelato tutti i dettagli di come funzionano i suoi algoritmi, quindi chiunque si affidi ad esso per rispondere a domande o creare prodotti utili per loro non sarebbe, allo stato attuale, del tutto sicuro di come sono stati creati.

In terzo luogo, l’output del sistema non è ancora perfetto. Sebbene possa gestire compiti come la creazione di testi brevi o applicazioni di base, il suo output diventa meno utile (in effetti, descritto come “incomprensibile”) quando gli viene chiesto di produrre qualcosa di più lungo o più complesso.

Questi sono chiaramente problemi che possiamo aspettarci di affrontare nel tempo: poiché la potenza di calcolo continua a diminuire di prezzo, viene stabilita la standardizzazione intorno all’apertura delle piattaforme di intelligenza artificiale e gli algoritmi vengono messi a punto con l’aumento dei volumi di dati.

Ringrazio Davide Simonelli, Alice Quattrocolo, Chiara Soleri ed Enrico Torchio ed i ragazzi dei gruppi di lavoro della 4C